Почему смартфоны так хорошо снимают и днем, и ночью? Что такое вычислительная фотография и почему за ней будущее

Камера в смартфоне, особенно флагманском — едва ли не основной элемент, на котором делают акцент как пользователи, так и производители. Оно и понятно: в мире, где для большинства юзеров одним из главных приложений является Instagram, качество снимков становится превалирующим фактором. Но как телефон с маленьким фотодатчиком может выдавать кадры, не просто сравнимые со снимками, сделанными профессионалами с помощью полноценных фотоаппаратов, но иногда даже превосходящие их? Все дело в так называемой вычислительной фотографии. Разбираемся, что это вообще такое и действительно ли будущее за алгоритмами, а не «руками мастера».

Что такое вычислительная фотография

Не нужно быть профессионалом, чтобы понять: уместить в корпус относительно небольшого смартфона матрицу камеры, сопоставимую по размерам с теми, что используются во «взрослых» фотоаппаратах, физически невозможно. Если упростить донельзя, то именно от размера фотодатчика зависит, сколько света сможет захватить техника и, соответственно, насколько качественным выйдет финальная фотография.

Короче говоря, матрицы в смартфонах маленькие, оптика — весьма посредственная. Что делать? Решение решили искать в так называемой вычислительной фотографии — проще говоря, в цифровом преобразовании данных, поступающих с камеры смартфона.

В сети любят приводить высказывание профессора Стэндфордского университета Марка Левоя о том, чем же вычислительная фотография отличается от обычной. По его мнению, технология «сочетает в себе набор методов компьютерной визуализации, позволяющих получить фотографию, которую технически невозможно сделать на данную камеру традиционным способом».

Физику не обманешь? Можно постараться, если применить современные фотодатчики вместе с мощным процессором

При этом важно понимать: изобретения в области железа смартфонных камер все же происходят. Например, один из трендов последних нескольких лет — объединение миниатюрных по размерам пикселей в один увеличенный (технология Quad Bayer). Такой подход применяют, например, в Samsung (маркетинговое название иное, но суть та же) и Xiaomi, номинально используя фотодатчики с разрешением 108 Мп, но на практике получая кадры со стандартным итоговым разрешением 12 Мп. В 2022 году инсайдеры обещают камеры разрешением уже 200 Мп (правда, про увеличение размера матрицы не говорят).

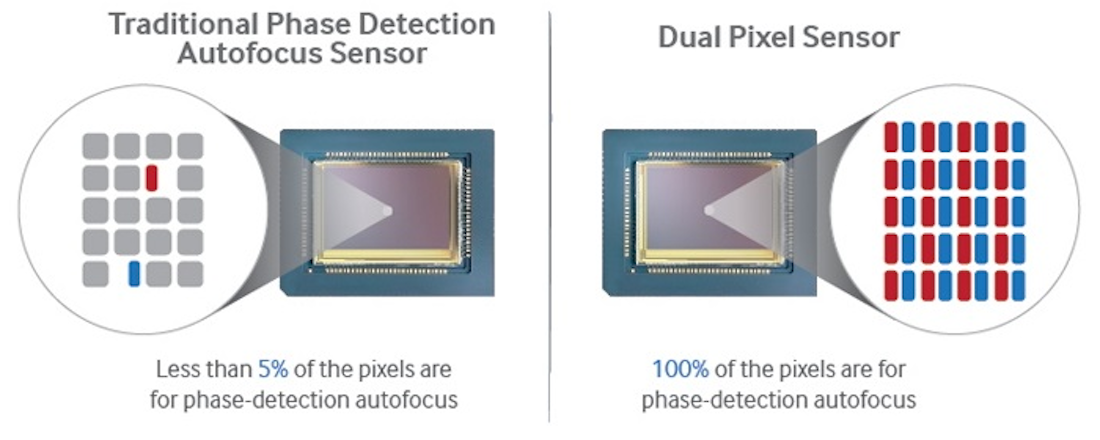

У той же Apple (впрочем, как и у многих других производителей смартфонов) подход иной: компания продолжает применять «классические» светосильные фотодатчики на 12 Мп (если считать по количеству фотодиодов, то даже на 24 Мп — впрочем, это не до конца корректно) с технологией Dual Pixel для улучшения автофокусировки.

Но опять же в обоих случаях эти технологии вкупе с другими физическими улучшениями вроде оптической стабилизации или встраивания сенсора LiDAR для измерения глубины объектов необходимы скорее для адаптации и последующей постобработки смартфоном с использованием вычислительной фотографии.

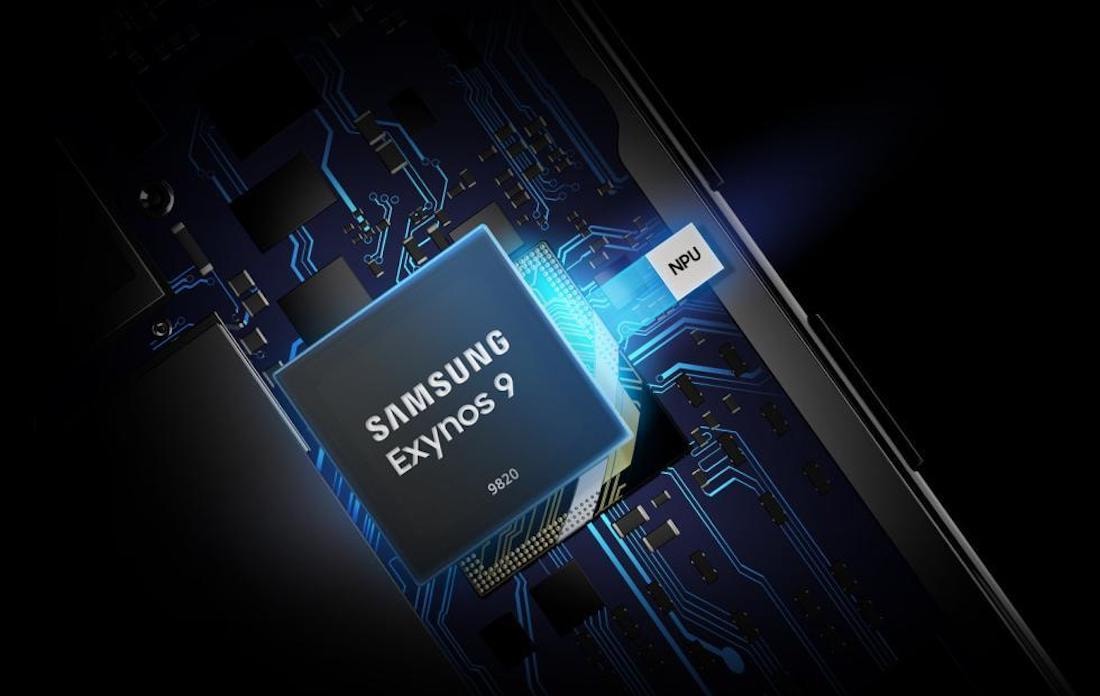

За последнее отвечают в первую очередь процессоры смартфонов (вернее, SoC), в которых установлены специальные модули, необходимые только для обработки поступающей с камеры информации. Разница между смартфоном начального уровня и дорогим флагманом заключается не только в том, насколько качественно действуют эти алгоритмы постобработки, но и в том, как быстро.

Условно говоря, кадр на iPhone в портретном или ночном режиме съемки либо при «склеивании» фотографий в HDR совершается за миллисекунды (на самом деле девайс фотографирует еще до нажатия кнопки затвора и помещает данные в буфер обмена — пользователь об этом просто не догадывается), а устройство за $200 от китайского бренда — уже за несколько секунд, о чем владельца гаджета оповещают на экране, попутно прося держать телефон неподвижно.

Короче говоря, за возможности вычислительной фотографии отвечает чипсет. Цифровое размытие фона (как при фото-, так и при видеосъемке), обработка цвета (например, чтобы кожа на лице была естественного цвета), в том числе с расширенным динамическим диапазоном, ночная фотосъемка, электронная стабилизация (если оптической или тем более матричной в устройстве нет) для компенсации от тряски рук — вот неполный пул задач, за которые отвечает железо аппарата.

Что такое стекинг, почему это важно и зачем смартфону NPU-модуль

То, что за процесс обработки снимков отвечает чипсет смартфона, мы уже выяснили. Но какие программные особенности, обеспечивающиеся этим железом, применяются чаще всего? Подробно про все эти особенности можно почитать здесь, а в этом материале остановимся на основополагающих моментах. Один из них — так называемый стекинг, или «склеивание» нескольких фотографий с изменением их параметров.

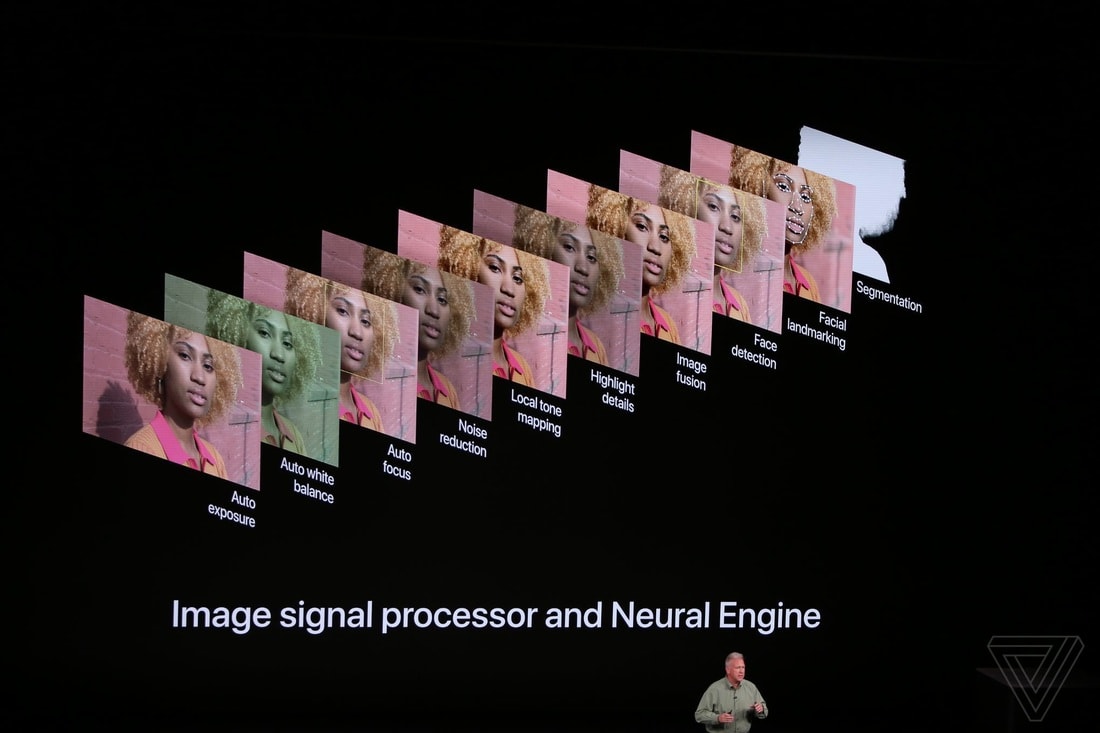

Сам термин «стекинг» производители телефонов на презентациях особо не применяют, зато активно используют его визуализации. По факту с помощью подобного «склеивания» с изменением параметров одного из заранее сделанных кадров (экспозиции, фокуса) создается снимок, который невозможно было бы получить при фотографировании без стекинга.

Если объяснять проще, то еще до нажатия кнопки затвора, в момент включения самого приложения камеры телефон начинает делать фото и сохраняет некоторые из них в буфер. При нажатии на кнопку спуска смартфон как бы заглядывает в прошлое и выбирает кадры с лучшими элементами: из одного кадра берет тени, из другого — детализированные изображения объектов, из третьего — еще какие-то элементы.

Разные комбинации различных настроек позволяют адаптировать фотографии для нескольких сценариев. Самый очевидный — автоматический HDR-режим. Представьте, что вы фотографируете друзей на фоне неба солнечным днем. Без соединения нескольких фотографий на одном кадре были бы видны только лица, а на втором, наоборот, небо вышло бы естественного цвета, но люди оказались бы не видны.

Этот пример базируется на «склейке» всего двух кадров, но алгоритм более мудреный и способен соединять элементы десятков изображений (чем мощнее аппаратная составляющая девайса, тем незаметнее этот процесс для пользователя). Это условно подтверждает и Apple, показавшая в этом году функцию под названием «Фотографические стили». Если по-простому, это умные фильтры, которые через нейросеть анализируют снимок, чтобы затем изменить цвет и контрастность, сохранив при этом естественными небо и людей. Опять же без хитрого стекинга и нейросетей тут не обошлось.

Второй, еще более насущный пример — ночная съемка. Еще года три-четыре назад вообразить, что смартфоны научатся буквально по нажатию одной клавиши делать кадры при недостатке освещения настолько качественными, было нельзя. Но сегодня благодаря все той же «склейке» нескольких фотографий с разной экспозицией ночные кадры выглядит так, как будто их, сделав на фотоаппарат с полноценной матрицей, обработали в Lightroom. Правда, в процесс обработки такого снимка на телефоне, как правило, подключается нейросеть — она самостоятельно выбирает необходимые детали на каждом фото. За это как раз отвечает отдельный модуль (NPU) в SoC-устройствах.

Наконец, выделяется еще «склейка» по фокусу. Не вдаваясь в детали, с ее помощью можно изменять глубину резкости постфактум, уже на готовом снимке. Да, для определения этой глубины объектов в кадре могут применяться физические датчики вроде того же LiDAR в iPhone, но сам эффект боке создается программно. Причем производители научились делать подобное настолько хорошо, что теперь переходят к видео. То есть мощности современных смартфонов хватает, чтобы в реальном времени определять глубину кадра, изменяя ее как во время видеозаписи, так и на постобработке.

Так что, вычислительная фотография — своеобразная панацея?

Если отвечать коротко, то вряд ли (во всяком случае пока). В определенных сценариях добиваться эффекта, который достигается профессиональной фототехникой, смартфоны еще не научились.

Условно говоря, заснять с трибуны бегущего спортсмена без смазов на телефон с рук проблематично. И это с учетом того, что во флагманских моделях начинают появляться фотомодули, способные снимать с 10-кратным оптическим зумом. Оптическим — это значит не полностью программным. Да, автоматика будет помогать с деталями, но не более. Программное увеличение с апскейлингом (по сути, увеличением четкости границ объектов) также присутствует в некоторых смартфонах — производители заявляют о кратности приближения изображения в 50 или даже 100 раз.

Но по качеству такие фото пока получаются весьма сомнительными (на момент публикации материала). В сети также часто вспоминают ситуацию, которая приключилась с Huawei. Несколько лет назад производитель на одной из презентаций заявил, что на его флагманское устройство получится фотографировать Луну. По факту же выяснилось, что гаджет просто заимствовал картинку с небесным телом из базы данных и умело вставлял ее в фотографию, делавшуюся человеком.

Подобные примеры, когда вычислительная фотография подменяет реальные объекты в кадре, достаточно редки. Все же смартфоны скорее усредняют и автоматизируют весь процесс обработки снимков таким образом, как сделал бы это профессиональный фотограф в фоторедакторе, вытягивая тени, общую насыщенность цветов, тон кожи и другие параметры.

Наш канал в Telegram. Присоединяйтесь!

Есть о чем рассказать? Пишите в наш телеграм-бот. Это анонимно и быстро

Перепечатка текста и фотографий Onlíner без разрешения редакции запрещена. ng@onliner.by