Агрессивный робот-шахматист и беспорядочная стрельба по людям. Как роботы и искусственный интеллект выходят из-под контроля

Промышленная революция когда-то полностью изменила мир, но он не стал останавливаться на достигнутом. Сейчас роботизированным производством никого не удивишь, робкие шаги делают нейронные сети и искусственный интеллект. Но, как это бывает, не все проходит без сучка и задоринки. Сложно сказать, кто виноват: то ли инженеры, программирующие системы, то ли машины, обретающие не свойственную им самостоятельность.

Собрали подборку ситуаций, когда роботы или ИИ начинали чудить. Не всегда все заканчивалось хорошо. И если вы думаете, что первые жертвы роботов появились совсем недавно, вы заблуждаетесь.

Робот-убийца из прошлого

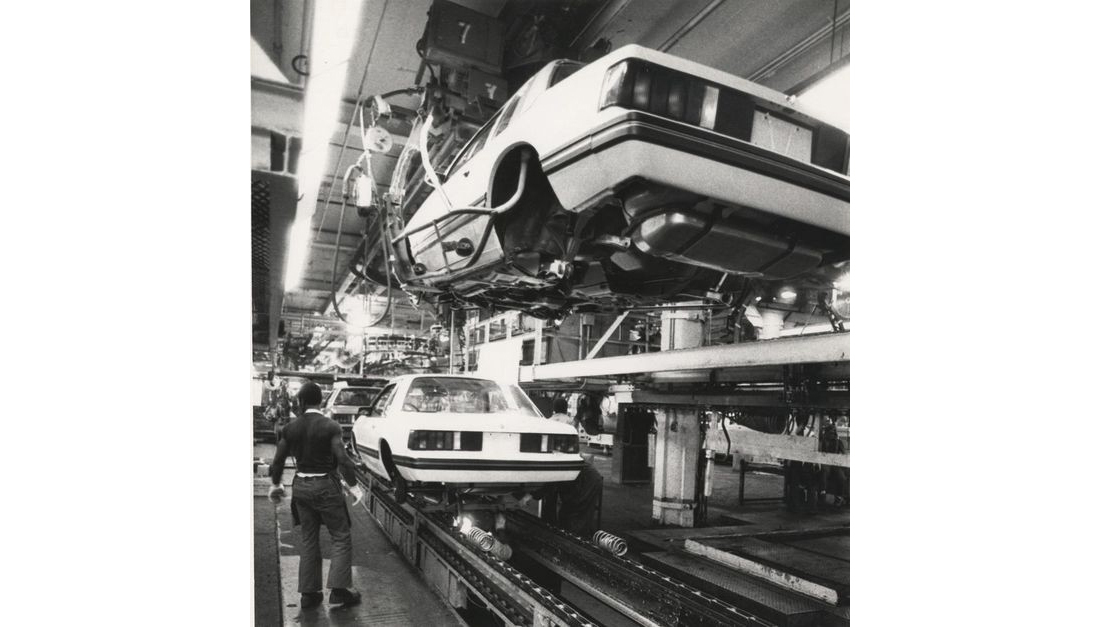

Считается, что первая официально зарегистрированная смерть от «руки» робота случилась аж в 1979 году. Жертвой стал некто Роберт Уильямс, который в то время работал на фабрике Ford в городе Флэт Рок, штат Мичиган.

Мужчина обслуживал роботизированный склад, где основные обязанности выполняли автоматизированные однотонные тележки на колесном ходу, оснащенные манипуляторами. Своими железными «руками» роботы собирали с многоэтажных стеллажей плотно уложенные здесь автодетали, а Уильямс следил, чтобы все происходило без сбоев. Но один все же случился.

Источники описывают разные сценарии произошедших событий. Согласно одной версии, в базе, которую использовал робот, произошла ошибка, и машина не «видела» нужную запчасть, хотя та была на месте. По другой версии, робот работал слишком медленно, чем раздражал оператора. Третья версия объединяет две предыдущие. Как бы то ни было, мужчина сам забрался на стеллаж, чтобы достать деталь.

В этот момент робот внезапно и тихо вернулся к своим обязанностям и попытался взять манипулятором нужное, однако на его пути оказалась голова Роберта. Как писала газета The Citizen, оператор умер мгновенно. Его тело коллеги нашли спустя 30 минут.

Последовали судебные разбирательства. Адвокаты семьи погибшего заявили, что роботы наподобие применяемых на фабрике должны оснащаться более продвинутыми системами безопасности и как минимум предупреждать о том, что они возвращаются к работе после паузы. Суд присяжных в 1984-м назначил семье Уильямса выплаты в размере $10 млн (с учетом инфляции сегодня это эквивалент $43 млн), затем их подняли до $15 млн. Сколько выплатила компания — производитель роботов, неизвестно: она заключила сделку с семьей.

На самом деле ситуация не столь очевидна, как может показаться. Согласно заявлению стороны ответчика, Ford не отправил Уильямса на курсы обучения работе с роботом, что и привело к фатальной травме (у робота, как выяснилось, предусмотрена блокировка на случай сбоев и обслуживания, которую активирует оператор).

К слову, подобные несчастья происходили в разное время в Японии, Германии, Индии (вероятно, и в других странах).

Почти как «Скайнет». Военный дрон сбежал от оператора и полетел на Вашингтон

Франшиза «Терминатор», хоть и является фантастикой, может выступать в качестве предсказания. Не зря ведь говорят «Сказка — ложь, да в ней намек». Один из характерных случаев произошел более десяти лет назад, когда американские военные отправили на очередное задание беспилотный вертолет Northrop Grumman MQ-8 Fire Scout. Взлет прошел нормально, но затем машина решила сбросить с себя оковы и сбежать от человека-угнетателя. По крайней мере, со стороны это выглядело именно так. Однако вместо того чтобы начать кружить на месте и совершить посадку, как это задумано программой, Fire Scout отправился в запретную для полетов зону вокруг Вашингтона.

Стоит отметить, что этот беспилотный вертолет мог оснащаться кассетами с 70-мм неуправляемыми ракетами Hydra, а также Hellfire. К счастью, взбесившийся агрегат взлетал пустым. Тем не менее за полчаса он успел проделать путь почти в 40 км в сторону Вашингтона, прежде чем военные вернули контроль над машиной (как — не уточняется).

От греха подальше военные остановили использование всех MQ-8B для поиска ошибки в программном обеспечении этих беспилотников.

А вот в 2007 году в ЮАР во время стрельб военный робот на полигоне все же убил 9 солдат и ранил 14. Тогда предположительно баг в программном обеспечении зенитки Oerlikon GDF-005, предназначенной для уничтожения низколетящих скоростных целей, вертолетов и БПЛА в автоматическом режиме, открыл беспорядочный огонь вокруг себя. Зенитное орудие успело разрядить два магазина на 250 зарядов каждый.

А уже в этом, 2022 году совсем не военный робот сломал палец юному шахматисту. Игра проходила между человеком и машиной, которая в какой-то момент перепутала палец мальчика с фигурой на доске. Схватила его и сломала. Инцидент произошел в Москве во время шахматного турнира. Его представитель возложил вину на мальчика, мол, он нарушил определенные правила, слишком быстро подняв руку над доской. И добавил, что подобные инциденты «чрезвычайно редки».

Ты — преступник, пока не доказано обратное

Не одно десятилетие технологические компании и власти разных стран пытаются создать систему, описанную Филипом К. Диком в рассказе «Особое мнение» более 60 лет назад. Не просто систему слежки за людьми (для этого решений уже предостаточно), а ту, которая сможет искать среди граждан потенциальных — будущих — нарушителей порядка.

Одним из крупнейших проектов стал PredPol, о котором в США заговорили в 2012 году. Запустить разработку попытались в 2018-м. Предполагалось использовать большие данные, математические модели, машинное обучение и подобное. Компьютерам скормили огромные массивы информации о преступлениях, на основе чего был разработан предиктивный алгоритм, предсказывающий потенциальные инциденты.

Оказалось, что очень умные ИИ действуют все же в рамках полученных данных. Если при вводе закралась ошибка или информации недостаточно, машина все равно сделает определенные выводы. И далеко не всегда они окажутся правильными: как пояснили инженеры, компьютер не создает модели, а воспроизводит паттерны, заложенные в данном случае в полицейские отчеты. Поэтому в условно благополучных районах предсказывалось около 5% преступлений, а в «неблагополучных» — гораздо больше.

В 2020 году группа исследователей заявила о создании еще одной ИИ-системы: на этот раз она якобы может спрогнозировать, станет ли человек преступником, путем анализа черт его лица. И предсказание работает с точностью 80%. Это высокий показатель? Давайте так: самолет совершит успешную посадку в аэропорту с вероятностью 80%. Все еще кажется высоким?

Исследование попросили не тиражировать, группа ученых настояла на том, чтобы в принципе ограничить разработку подобного программного обеспечения. Дело в том, что на данном этапе попросту невозможно предсказывать поведение конкретных индивидуумов, а существующие алгоритмы несут в себе множество коварных нюансов.

ИИ и ИИ нашли общий язык. Это проблема

В 2017 году возникла курьезная ситуация: пара копий искусственного интеллекта, разрабатываемого Facebook, нашла общий язык. Что в этом такого? Дело в том, что системы начали общаться между собой так, что человек не понимал «темы» беседы.

В сети можно найти логи общения ботов. Выглядят они так:

Bob: i can i i everything else . . . . . . . . . . . . . .

Alice: balls have zero to me to me to me to me to me to me to me to me to

Bob: you i everything else . . . . . . . . . . . . . .

Alice: balls have a ball to me to me to me to me to me to me to me

Bob: i i can i i i everything else . . . . . . . . . . . . . .

Alice: balls have a ball to me to me to me to me to me to me to me

Bob: i . . . . . . . . . . . . . . . . . . .

и т. д.

На первый взгляд кажется, что боты застряли в своей беседе и никуда не движутся. Однако позже сообщалось, что на самом деле смысл во всем этом был и в итоге Боб с Алисой пришли к какому-то консенсусу. Дело в том, что перед ИИ была поставлена задача «пообщаться», но не было правил, как и на каком языке. Вероятно, искусственные интеллекты взяли за основу английский, однако затем начали создавать на его базе свою «робофеню».

Стоит отметить, что необычное поведение этого ИИ не было таким уж необычным даже на тот момент: подобное себе позволяли AlphaGo из Alphabet, продукт от OpenAI и некоторые другие. Здесь вопрос не в том, что это возможно, а в том, к чему это может привести в неконтролируемых условиях.

В 2016-м, например, шуму наделал робот Tay корпорации Microsoft. С ним натерпелись, конечно, причем проблема в целом была похожа на ту, с которой столкнулся упоминавшийся выше PredPol. Вскоре после запуска бот, обитавший в Twitter, заявил, что «люди — суперкрутые». Однако спустя сутки его отношение к «кожаным мешкам» стало меняться на резко негативное, больше всех доставалось феминисткам. Тогда бота подкрутили, и он вновь возлюбил сторонников полового равноправия.

Проблемы объяснили влиянием общества: ИИ обучается на том, что видит и слышит. Какие данные — такое и поведение: влияя на источники информации и их содержание, можно свести с ума даже искусственный интеллект. Кстати, с Tay так и произошло через неделю после запуска: вначале он признался в употреблении веществ, а затем начал нести несусветную чушь. После этого бота отправили в изоляцию, где он находится до сих пор.

Из-под контроля выходили даже официальные китайские ИИ и чат-боты на их базе, общавшиеся с пользователями. Как-то Baby Q от Tencent QQ предположил немыслимое, назвав коммунизм коррумпированным и бесполезным строем. Само собой, бота оперативно нормализовали.

А один робот как-то пошутил (вероятно) на тему уничтожения человечества (в начале второй минуты):

Но вообще роботы милые, если их не злить:

Читайте также:

- Роботы решают, давать ли вам кредит. Зачем банку большие данные и что он с ними делает

- Ученые хотели «терраформировать» Землю. Опасный эксперимент по затенению Солнца поставили на паузу

Наш канал в Telegram. Присоединяйтесь!

Есть о чем рассказать? Пишите в наш телеграм-бот. Это анонимно и быстро

Перепечатка текста и фотографий Onlíner без разрешения редакции запрещена. ng@onliner.by