Вы никогда туда не проберетесь. Посмотрели, как работает «центр управления» белорусскими сайтами

Где крутятся серверы, откуда работают сайты и происходят другие непонятные для человека извне вещи? Мы побывали в дата-центре, посмотрев поближе на то, как он устроен: из чего состоит и как там обеспечивают безопасность. В центре обработки данных многие процессы происходят незаметно в стойках с серверным «железом». Можно ли на работающем сервере пожарить яичницу и почему путь к нему лежит через липкий пол? Вместе с hoster.by разберемся во всех аспектах работы современного дата-центра и устройстве IT-систем.

Что такое ЦОД?

Зачем вообще нужны ЦОД и что это такое? В народе их называют дата-центрами, потому что здесь хранят и обрабатывают дату (данные). ЦОД может представлять собой одно здание или целый комплекс сооружений, это зависит от того, на какие задачи он ориентирован, с какими объемами и типами данных и трафика работает. В Беларуси их около десятка: пять в Минске и по одному в областных городах.

Здесь создается специальная среда для размещения серверов, сетевого оборудования и систем хранения и обработки тех самых данных. Что за данные? Веб-сайты, интернет-магазины, различные интернет-сервисы (например, почта или CRM), это могут быть закрытые для внешнего мира корпоративные ресурсы.

Грамотная инфраструктура — один из важных компонентов: с ней банально сайт не будет зависать, он сможет быстро грузиться, появится возможность работать с большими базами данных, и при этом обеспечивается безопасность.

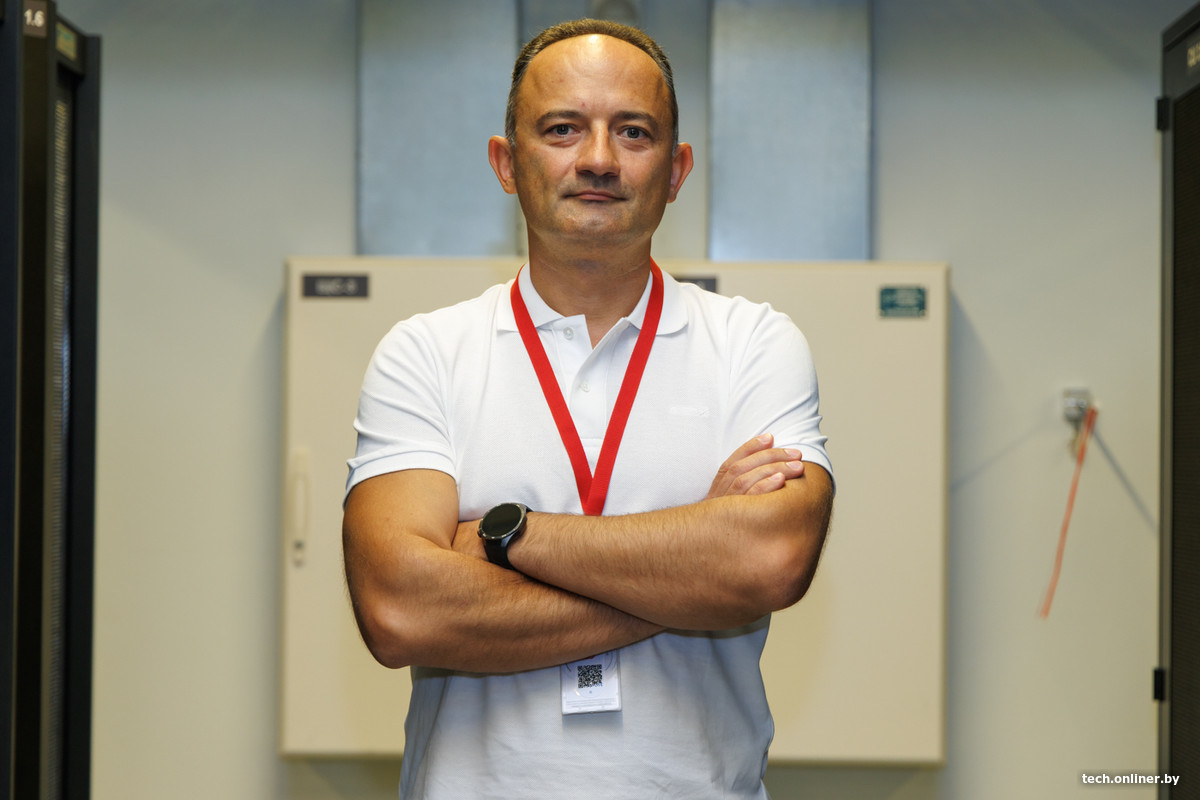

«Говоря о работе любого онлайн-проекта, важно знать о трех уровнях, на которых держится его быстрая и безопасная работа. Это собственно уровень дата-центра, программно-аппаратный уровень, за который, как правило, отвечает провайдер, и последний — само приложение или сайт, — комментирует технический директор hoster.by Денис Отвалко. — То есть, если проект перестал работать или замедлился, проблема может быть на любом из этих уровней. А если говорить о безопасности, она тоже должна быть на каждом из них».

Физическая безопасность: шлагбаум, пропуски, липкий пол и стеклянный куб

Мы отправились в ЦОД МДА недалеко за МКАД. С улицы попасть сюда просто так не получится, путь на территорию перекрывает шлагбаум с интеркомом и камеры, на входе нужен либо электронный пропуск, либо смелость побеспокоить человека на ресепшене. Хотя и это ни к чему не приведет, так как оказаться внутри можно либо по записи, либо по спискам клиентов дата-центра.

В «святая святых» зайти можно лишь через футуристичное для человека, не бывавшего в подобных местах, сооружение: небольшое прозрачное помещение с парой стеклянных автоматических дверей на противоположных сторонах. Заходить в него нужно по одному, так как пол выполняет роль весов и может что-то заподозрить: мало ли, кто-то лишний просочится.

На выходе из бокса, занимая почти всю поверхность пола, уложен липкий мат. Пробежать по такому вряд ли получится, да и некуда: дальше снова дверь, требующая электронный пропуск. А мат нужен в первую очередь для того, чтобы снять всю грязь (пыль, в частности) и статику с обуви.

Внутри прохладно, другое давление, по трубам течет деионизированная вода

Потом дорога в «гермошлюз», за которым обеспечивается необходимое давление воздуха внутри помещения, где установлены серверы, накопители и сетевое оборудование. В машинном зале своя атмосфера: во-первых, люди там бывают редко, только при необходимости обслуживания или быстрого реагирования на инцидент. Во-вторых, достаточно шумно, так как работает система вентиляции, к тому же нагнетающая давление. Температура воздуха здесь не должна превышать 25 градусов, 30 — уже опасный предел, и система выдает предупреждение. А если вдруг 35 — это авария: сигнализация в таком случае срабатывает во всем ЦОД и отправляет сообщение на пост охраны.

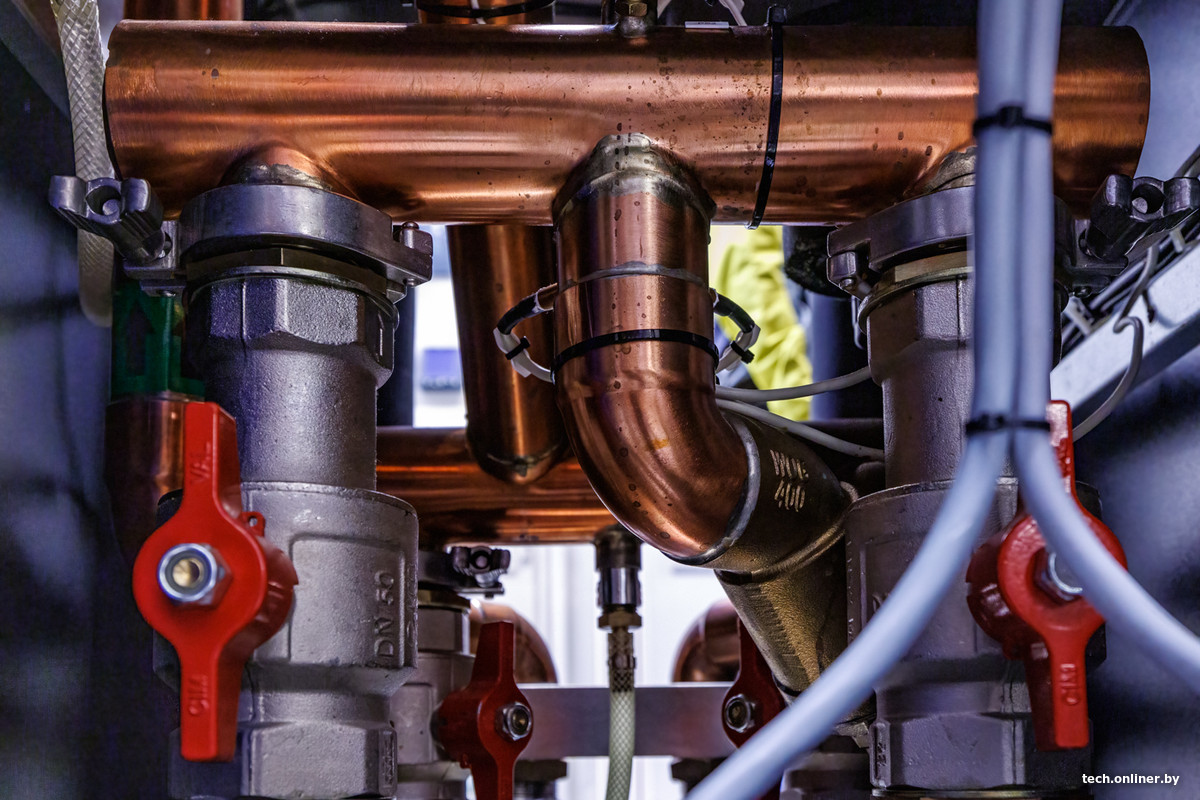

Но в других дата-центрах бывает и более шумно: в нашем случае охлаждение водяное и, судя по всему, такое в Беларуси больше нигде не встречается в подобных масштабах. Нет, стойки не утоплены в бассейнах (хотя было бы красиво), а установлены в шкафах, двери в которых представляют собой радиаторы во весь рост.

В них и струится специально подготовленная жидкость (в зависимости от контура это гликоль и деионизированная вода).

«ЦОД — это инженерная инфраструктура: гарантированное электропитание, охлаждение, обеспечение пожарной и физической безопасности. Все системы здесь задублированы, — рассказывает Денис Отвалко. — Любой перегрев чреват последствиями. Да, внутри сервера температура может быть и 80, и даже 100 градусов, но серверное оборудование отличается от обычных компьютеров. Там другая система охлаждения, другой формфактор корпусов и все остальное. А вот для воздуха в ЦОД 30 градусов — уже не норма, должна поддерживаться температура в 22—24 градуса. Получается, что зона комфорта тут у людей и машин примерно одинаковая».

Температура (да и вообще всё) управляется электроникой, которая среди прочего контролирует точки росы: конденсат никому не нужен. Везде стоят умные распределители питания, есть два вводно-распределительных устройства, которые питаются от пары независимых подстанций, имеется дизель-генераторная установка на случай чего. Вводы резервов происходят автоматически при необходимости, дизель запускается менее чем за две минуты.

Насосы, отправляющие теплоносители в трубы, находятся в отдельном помещении: здесь сухо и тепло, элементы, на которых может образоваться конденсат, закрыты специальным покрытием. А тепло здесь из-за теплового насоса, который забирает подогретый гликоль из машинного зала и передает его на систему теплоснабжения, в том числе отопления (зимой ЦОД и рядом стоящий ФОК отапливаются… серверами).

Из необычного для стороннего человека — стеклянные люки в полу, необходимые для быстрого доступа к инфраструктуре системы охлаждения: трубам и запорам. Рядом с ними проложены кабели — детекторы влаги.

В отдельном (и тихом) помещении располагаются операторы, которые следят за состоянием оборудования и инфраструктуры удаленно: здесь несколько огромных мониторов, куда выводят данные со всех компонентов, и несколько компьютеров с дисплеями поменьше. Ничего «космического» и никаких пультов с механическими тумблерами, почти привычное офисное помещение.

Тут можно увидеть, в какие именно шкафы с оборудованием и помещения открывались двери. Сюда же выводится информация с датчиков и сенсоров оборудования: температурный режим, работа кондиционеров, уровень влажности, давления, энергопотребления и т. д.

Информационная безопасность: это не одно действие, после которого все станет хорошо

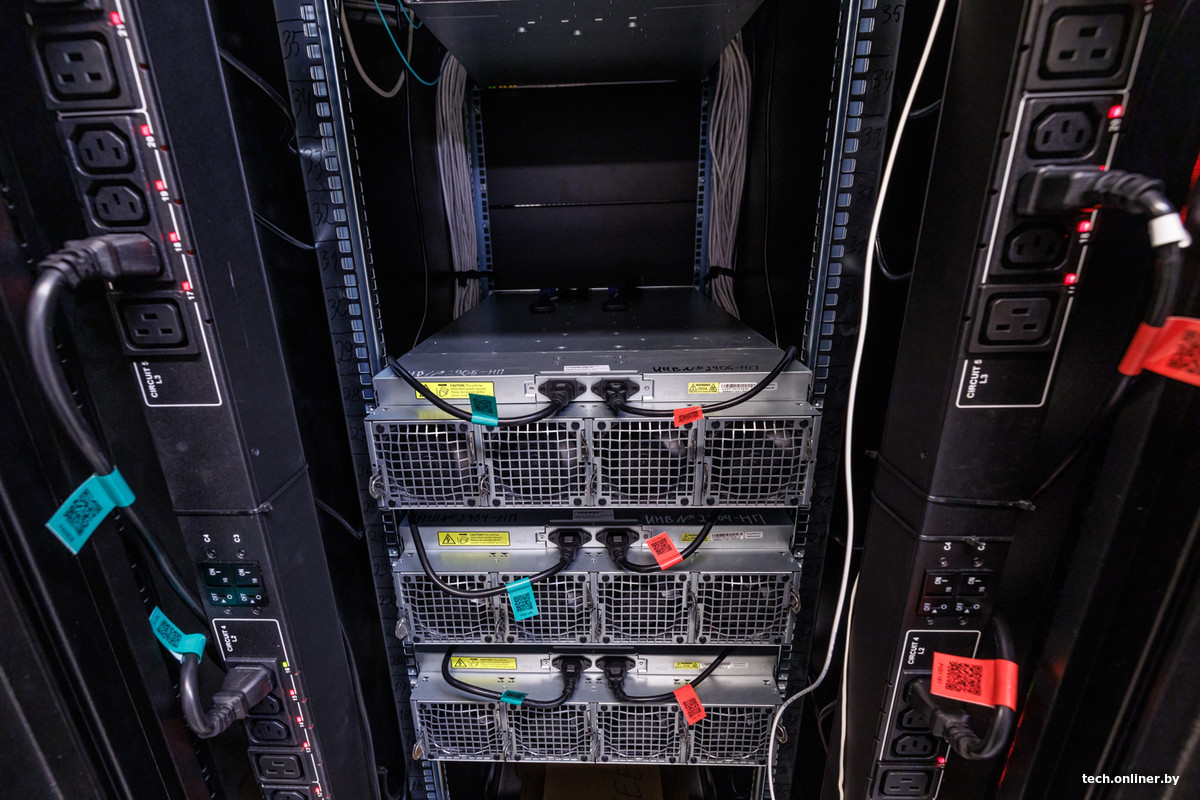

А что происходит дальше? От инженерного уровня дата-центра переходим к «начинке» — серверному уровню. Серверы и сетевое оборудование размещают в ЦОД представители провайдеров или непосредственно клиенты.

«Все критически важные элементы сетевого оборудования имеют физическую избыточность, то есть тут всегда как минимум на один элемент больше, чем необходимо для обычной работы. Если выйдет из строя коммутатор или оборвется кабель — все автоматически пойдет по резервному пути и не приведет к сбоям, — комментирует Денис. — Каждый сервер подключается несколькими путями к сетевому оборудованию, то же касается систем хранения данных. Все системы на всех этапах резервируются: контроллеры, питание, сетевые подключения и так далее».

По его словам, одним из самых надежных способов размещения проектов с точки зрения отказоустойчивости является облако: это группа серверов, объединенных в кластер, в котором «крутятся» проекты клиентов. Если на каком-то сервере происходит сбой или проблема во всем дата-центре, то ресурсы клиента автоматически мигрируют на доступные серверы из кластера. При этом для большей надежности клиенты могут размещать свои проекты одновременно в разных дата-центрах.

«В целом бесперебойность проектов — это история не про минимализм. Дублируются не только элементы инфраструктуры и оборудование, используются специальные программно-аппаратные решения для хранения данных. Не говоря уже о нескольких типах резервных копий, которых никогда не бывает слишком много. Кроме того, правильная облачная инфраструктура поддерживает live-миграцию. Это позволяет перемещать запущенную виртуальную машину с одного физического хоста на другой. При этом сам сервер и ресурсы клиента остаются доступными, а системный администратор может проводить необходимые работы», — объясняет Денис.

Если же проект размещается не в облаке, а на выделенном сервере, то на первый план выходят требования к его производительности. Особенно это актуально для компаний, использующих CRM, ERP и программы с нагруженными базами данных. Поэтому важно, чтобы провайдер регулярно обновлял парк серверного оборудования и использовал современные процессоры и высокоскоростные диски.

Используются и несколько операторов связи, то есть речь о резерве не только сетевого оборудования, но и внешних подключений, провайдеров. Можно ли использовать мобильную связь для этого? Разве что в качестве резервного канала администраторами для внутреннего управления.

«Физическая безопасность в первую очередь касается самого ЦОД: шлагбаумы, двери, видеонаблюдение, проходные шлюзы. Далее используются различные СЗИ (средства защиты информации). Мы используем Anti-DDoS от операторов и СЗИ, которые установлены уже в нашем контуре: например, межсетевое экранирование, системы обнаружения и предотвращения вторжений (IPS/IDS), средства фильтрации трафика и некоторые другие. На программном уровне мы отслеживаем все инциденты, все сервисы подключены к нашему центру кибербезопасности. Он мониторит инфраструктуру, пишет логи и реагирует в случае внештатных ситуаций».

По словам Дениса, самым уязвимым уровнем, через который происходит бо́льшая часть кибератак, является непосредственно уровень клиентского приложения: уязвимости движка, ошибки при разработке, человеческий фактор (например, простые пароли или отсутствие практики удалять доступы к системе уволенных сотрудников). И это тот уровень, на который провайдер не может повлиять.

«Информационная безопасность — это не какое-то одно простое действие, после которого все станет хорошо. Это комплекс мер, которые нужно предпринимать ежедневно, постоянно. Можно использовать условный WordPress, и его никто не „сломает“. А если не обращать внимания на обновления, на управление доступами и подобное, тогда вероятность будет выше вне зависимости от того, какая CMS используется», — рассказывает эксперт.

Хотя остается верным утверждение: если что-то хотят взломать, вне зависимости от того, насколько оно защищено, систему «достанут».

«Все зависит от интереса, от степени погружения. По большому счету, да, на 100% защищенных систем не бывает», — говорит эксперт.

Эффективней реагировать превентивно, и это касается всех аспектов. Да, вспоминается анекдот про сисадмина, который днями ничего не делает, но на деле лишь потому, что у него все настроено «как надо».

«Если мы видим, что зарождается проблема, мы стараемся ее решить до того, как она превратится в катастрофу. Большинство из них, как известно (и не только в IT-сфере), можно предупредить. Крутая инфраструктура — это та, которая не „падает“ и не будит по ночам. А если что-то происходит, работа не останавливается, и проблему можно решать в спокойном режиме. Потому для стабильной работы всех систем важно реализовать мониторинг доступности всех важных перечисленных выше систем и комплексов 24/7».

Партнер проекта – hoster.by

hoster.by – надежный провайдер с 25-летним опытом построения и сопровождения IT-инфраструктуры, эксперт по кибербезопасности.

hoster.by предоставит готовые IT-решения для вашего бизнеса:

— Гибкое отказоустойчивое облако с прозрачной тарификацией.

— Производительные выделенные серверы.

— Частные и гибридные облака, решения с повышенными стандартами защиты.

— hoster Guard – комплексное SaaS-решение для защиты сайтов и приложений.

— Аттестация СЗИ с возможностью аудита персональных данных.

Спецпроект подготовлен при поддержке ООО «Надежные программы», УНП 100160363.

Есть о чем рассказать? Пишите в наш телеграм-бот. Это анонимно и быстро

Перепечатка текста и фотографий Onlíner без разрешения редакции запрещена. ga@onliner.by