Разбор: как именно искусственный интеллект создает настолько пугающе реалистичные изображения?

О том, что искусственный интеллект якобы заменит человека в разных областях, оставив нас без работы, говорят уже больше пяти лет. Но в последние несколько месяцев активность разговоров такого рода кратно возросла — в сети едва ли не каждый день появляются заметки о расширяющихся возможностях лингвистических моделей (ChatGPT и аналогов), а также о новых успехах «художественных» ИИ для генерации изображений. Последние и вовсе наделали много шума, «подделав» задержание Трампа и примерив на папу римского Франциска образ хипстера в модной куртке. Но как именно подобным ИИ удается создавать столь реалистичные изображения, какие технологии для этого используются и заметен ли прогресс? Разбираемся.

Диффузионные модели — наше все?

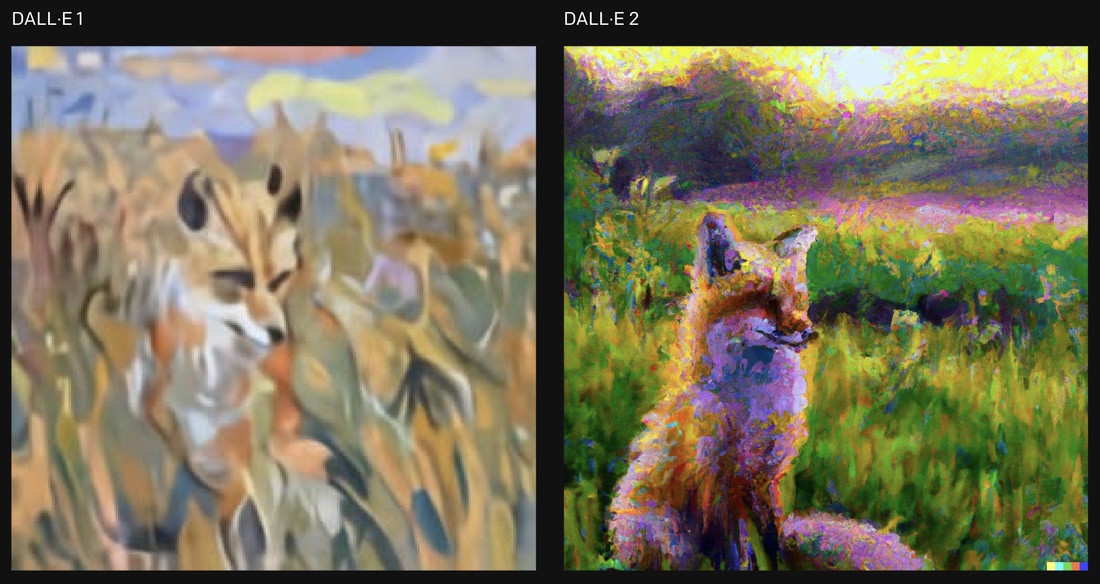

Задержанный Трамп и модный папа Франциск были созданы ИИ под названием Midjourney — в сфере генерации изображений по текстовому запросу этот инструмент в последнее время упоминается чаще всего. Впрочем, он далеко не единственный. В прошлом и позапрошлом годах, например, бал правили версии DALL-E — их разработкой в том числе занимались в компании OpenAI, которая ответственна за ChatGPT.

О последнем мы недавно рассказывали в подробностях — с февраля наш материал актуальности не утратил, хотя сам бот успел обновиться до четвертой номерной версии и получить несколько новых фишек. Одна из самых интересных — способность создавать код не просто на основе пользовательского запроса, а через анализ рисованной от руки картинки (например, несложного веб-сайта).

Но «художественные» нейросети, генерирующие изображения по тексту юзера (text-to-image), работают слегка иначе — в основе большинства современных моделей находятся разновидности так называемых диффузионных моделей. Они уважаемы за несколько важных преимуществ, среди которых выделяют «вариативность генерированных картин» наряду с «достаточной стабильностью».

«Последовательный математический алгоритм»

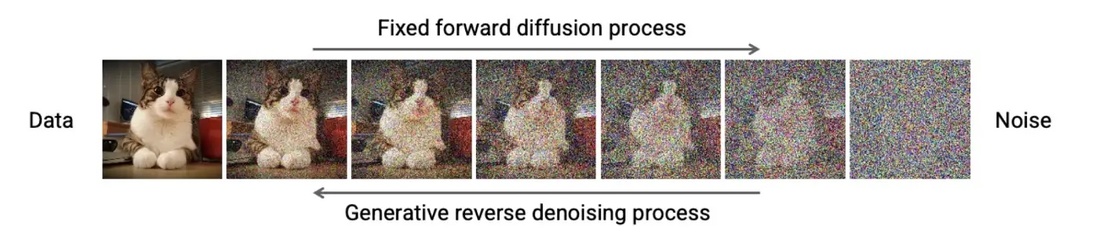

Но что термин «модели диффузии» вообще означает? Если упростить, то речь про специальные техники шумоподавления, представленные специалистами Стэнфордского университета (США) в 2015 году. Одна из базовых диффузионных моделей, DDPM (Denoising Diffusion Probabilistic Model), действует примерно так: ее пошагово обучают на базе данных из нескольких сотен тысяч изображений, где на каждом шаге к картинке из выборки добавляется случайный шум (определенной заранее силы, его еще называют Гауссовский шум).

Сначала шум относительно невелик, после усиливается и на конечном этапе становится более чем заметным. Процесс выглядит как на кадрах ниже. Можно провести аналогию с плохо ловящим сигнал «пузатым» телевизором:

Второй этап: нейронку тренируют так, чтобы она могла обращать подобные «зашумления» в обратном порядке — по сути, повышать качество «порченного» изображения. Но исследования показали: если итеративно (пошагово) применять обратную модель — обращать изображения с Гауссовским шумом в противоположном направлении, при этом не перескакивая итерации, — она окажется способна сгенерировать полностью новое изображение. Да, оно походит на оригинал, но все же является высокоточной копией.

Эффект назвали просто — обратной диффузией. Если упростить, за ним скрывается лишь последовательный математический алгоритм, который в том числе возможно запустить по текстовому запросу.

В общем, концепция выглядит так:

- берем изначальное изображение (в выборке их сотни тысяч);

- итеративно добавляем Гауссовский шум, пока от исходной картинки практически ничего не останется;

- обучаем модель шумоподавления приводить пиксельную «кашу» к результату, похожему на исходное изображение.

Текстовые «подсказки» не менее важны

Но как нейронке понять, что именно нужно восстановить из шума? Есть несколько способов, но общепризнанный такой: шум, из которого генерируется изображение, сочетается с каким-то условием. В случае с упомянутыми ИИ (Midjourney, DALL-E, Imagen) это условие выражается текстом.

С точки зрения пользователя все просто — необходимо сделать запрос наподобие «Minsk at night». С точки зрения ИИ процесс чуть сложнее: для создания изображения нужно применить языковые модели, обученные на парах картинок с подписями. Причем подобные модели должны быть способны понимать смысл изображений и текстов одновременно.

Пример такого усовершенствованного подхода называется CLIP (Contrastive Language Image Pre-training), его придумали инженеры OpenAI. В нем используется метод перевода изображения и текстов в общее векторное пространство. В последнем ищутся ближайшие к текстовому запросу картинки — все это просто алгебраическая операция.

Проще говоря, диффузия получает дополнительный способ восстановить исходное изображение из «шумного источника» через известный контекст — текстовые подсказки. Похоже на то, как в обывательском сознании работают «художественные» ИИ?

Позднее диффузионные модели прошли (и проходят до сих пор) еще несколько итераций по улучшению. Например, они научились создавать изображения из так называемого направленного шума (многие модели text-to-image сегодня работают именно так).

Причем каждый из разработчиков сам определяет, какие способы обучения применять (и, что важнее, как их объединять). Например, представители Midjourney до сих пор не разгласили какие-либо особенности своего исходного кода, продолжая говорить про «обученные на собственном суперкластере модели». Впрочем, как бы в компании ни старались не акцентировать на этом внимание, сторонние эксперты подтвердили — в основе Midjourney также лежит диффузия.

Какие у диффузных моделей есть ограничения?

Зачастую кажется, что почти никаких. Во всяком случае, прогресс ИИ-моделей за короткий срок более чем очевиден для неподготовленных зрителей. В прошлом мае мы сделали большой материал, в котором рассказали про особенности работы с моделью DALL-E.

Один из основных тезисов звучал так: «DALL-E совсем не идеальна. Если присмотреться к ее художествам, то можно разглядеть недочеты. Да и показывают нам, как правило, только самое впечатляющее и удачное». Но тогда речь шла о генеративной картинке «лисы, сидящей в поле», а не изображениях человека.

Ниже показаны возможности Midjourney v5:

Изображения человека у нейронок как раз получались хуже всего. Автоматика промахивалась то с количеством и/или «дизайном» пальцев на руках, то с волосами. Но меньше чем за год системы продвинулись настолько, что правительства целых стран бьют тревогу, вводя временные ограничения на лингвистические модели, а эксперты отрасли публикуют открытые письма с призывом приостановить разработку моделей до написания общих для отрасли стандартов.

Но все ли так серьезно? Мнения разделяются. Некоторые исследователи утверждают, что, несмотря на весь прогресс диффузных моделей, связанные с ними ограничения — например, в генерации текстов на изображениях — все еще существенны. Люди также выходят не идеальными, хотя и приближенными к таковым (судя по рендерам выше) — затруднения чаще всего встречаются с зубами.

Кроме того, контроль над «художественными» ИИ на фоне скандалов с искусственными изображениями известных личностей берут сами разработчики. Например, в Midjourney закрыли бесплатный доступ к ИИ-модели (хотя глава компании и утверждает, что с «задержанным Трампом» это решение никак не связано). А еще ограничивается список текстовых запросов, с которыми подобные модели могут работать.

Наш канал в Telegram. Присоединяйтесь!

Есть о чем рассказать? Пишите в наш телеграм-бот. Это анонимно и быстро

Перепечатка текста и фотографий Onlíner без разрешения редакции запрещена. ng@onliner.by