«Еще не совершили преступление? Тогда мы идем к вам». Как ИИ попытался прогнозировать правонарушения и к чему это привело

«Еще не совершили преступление? Тогда мы идем к вам». Как ИИ попытался прогнозировать правонарушения и к чему это привело

Когда случилось первое преступление? Вероятно, когда был нарушен первый изданный закон. Не будь правил, никто не смог бы их нарушать: ведь нечего. Многие вещи впитываются, что называется, с молоком матери: социальные и любые другие нормы, которые позволяют оставаться незапятнанным с точки зрения закона. Другие описываются в специальных документах.

К происходящим процессам адаптируются все: и те, кто нарушает, и те, кто придумывает новые ограничения. Поэтому одни правила (они же законы) сменяются другими, добавляются новые, исчезают утратившие актуальность. Есть общества, сумевшие добиться «гармонии» или высокого уровня безопасности. Существует множество рейтингов, в которых перечислены страны от худших до безопаснейших. На первых местах чаще оказываются Катар, ОАЭ, Тайвань, остров Мэн, Оман, Швейцария, Гонконг и ряд других (со списком можно ознакомиться по ссылке).

Мы отправимся в первую половину рейтинга, где между Украиной и Никарагуа расположились США. Здесь в 1928 году родился Филип К. Дик — автор научной фантастики, написавший в 1956 году рассказ «Особое мнение». В нем, напомним, троица мутантов, подключенная к предиктивной машине, умела предсказывать будущее. Точнее, будущие преступления. А чтобы они не произошли, к делу подключался специальный отряд.

Спустя примерно 60 лет после публикации рассказа оказалось, что идея, заложенная в «Особом мнении», реализуема. Ведь наступала эпоха «больших данных», «облаков» и все растущей вычислительной мощности компьютеров. Так, в 2012 году громко заявил о себе проект PredPol (происходит от словосочетания predictive policing — сам термин относительно новый, подобные технологии стали применяться в мире с начала нулевых). На пике развития PredPol называли «лидером прогнозирования преступлений».

Это классическое прогнозирование на базе математических моделей с обработкой массивов доступных данных (статистики), хоть и со своей спецификой и с добавкой машинного обучения. Подобным образом работала и другая платформа, применяемая американской полицией, — Operation LASER. Проблема оказалась не в том, как собираются данные, а в том, какие результаты выдает система. И вновь возникает аналогия с «Особым мнением».

В основу PredPol положили алгоритм предсказания сейсмической активности после землетрясений. К делу подключалось машинное обучение, обрабатывая все новые данные из полицейских отчетов (после первичного обучения системе «скормили» информацию о преступлениях за прошедшие 10 лет). Целью было создание предиктивного механизма, рассказывающего, где, когда и какое преступление готовится к совершению в пределах ближайших 12 часов. Применять алгоритмы можно было для ловли наркодилеров, угонщиков, воров и кого угодно еще.

Система действовала с переменным успехом, развернувшись к 2018 году. С переменным — потому что никто не мог оценить реальную эффективность PredPol. Кроме того, со временем стало понятно, что работает она как-то «не так».

Вокруг PredPol начали сгущаться тучи, а полицейские все больше критиковали платформу. Эксперты, поддерживающие ее, писали: «PredPol используется уже в более чем 60 полицейских департаментах по всей стране». Критикующие в тот же момент времени были чуть более конкретны: «PredPol используется в 60 полицейских департаментах из 18 тыс.».

Одновременно PredPol пыталась лоббировать свои интересы, предпринимая усилия для получения госконтрактов на миллионы долларов. Однако на волне критики это не удавалось.

Пролить свет на происходящее позволила утечка данных: в распоряжении журналистов Gizmodo и The Markup оказалось 7,4 млн сгенерированных PredPol отчетов, хранившихся на незащищенном сервере. На эту тему в декабре 2021 года вышел материал-расследование. Но еще до этого момента прогнозирующая система привлекла внимание экспертов.

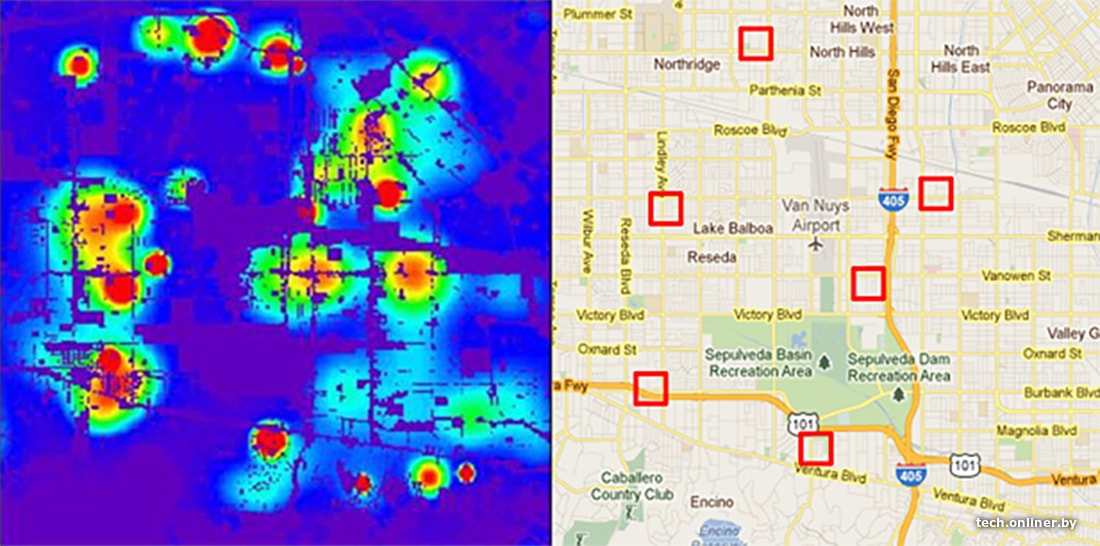

С точки зрения обработки данных к PredPol вопросов не возникало: она делала то, для чего была разработана — анализировала поступающую информацию и предлагала прогнозы. Полиция получала наводки, точнее «тепловые карты», в горячих зонах которых могли (или должны были?) совершаться преступления. Также стало известно, что за период с 2018 по 2021 год как минимум 33 конкретных индивида попали под подозрение полиции на основании предсказания PredPol. При этом некоторые районы-рекордсмены за отчетный период набирали 11 тыс. прогнозируемых правонарушений — это много.

Да, городские районы из выборки стали средоточием преступности: система предсказывала по несколько серьезных правонарушений в день. Другие оставались полностью «белыми», без единого прогноза, что невозможно. Одновременно считалось, что система полностью лишена предрассудков, а безэмоциональный ИИ не может колебаться. Идеальный мир не за горами? Или дистопия?

На самом деле все было не так безоблачно. Представитель полиции небольшого городка Рио-Ранчо в штате Нью-Мексико рассказал, как PredPol обозначила удаленную область в пустыне «горячей точкой», требующей повышенного внимания: ИИ посчитал, что там регулярно происходят преступления — кражи автомобилей. Подобный вывод, как выяснилось, был сделан после того, как там обнаружили одну брошенную (и до этого действительно угнанную) машину. Но это самый безобидный пример. Тем более в ответ разработчики PredPol заявили: ПО может предоставлять неверную информацию, если вводных данных недостаточно.

Но в этом и заключается основная слабость как PredPol, так и аналогов (вероятно, COMPAS, CrimeScan и других, применяемых в США).

Статистик Кристиан Лам из организации Human Rights Data Analysis Group (занимается сбором информации о нарушении прав человека в мире) в Сан-Франциско пояснил: алгоритм делает то, что задумано, изучая модели, заложенные в данных. Однако опасно думать, что прогнозы расскажут о закономерностях возникновения преступлений: на самом деле они расскажут о паттернах в полицейских отчетах.

В связи с этим, считает Лам, действуя по старинке, полиция может ошибиться с меньшей долей вероятности, нежели при использовании спецалгоритмов, которым «как бы» не свойственны расизм и предрассудки.

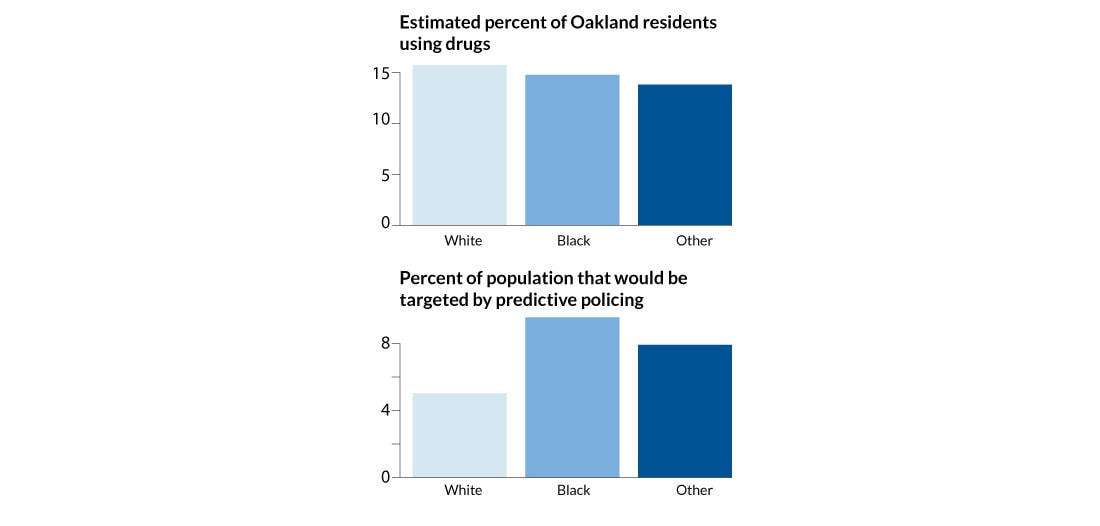

Другие примеры указали на основную слабость данного ПО. Как гласили отчеты, оказавшиеся в распоряжении Gizmodo, PredPol рекомендовало усилить патрулирование в районах города Портридж, где черное население в девять раз превосходит среднее по городу белое. Аналогичная ситуация сложилась в Бирмингеме. В Лос-Анджелесе прогноз указал на «белый» район, но выбрал квартал, где проживает почти 100% латинос. В Чикаго PredPol прогнозировало больше преступлений там, где живут латинос и менее обеспеченные граждане. Может, оно на самом деле так? Не совсем, потому что это же ПО предсказало в «белом и богатом» районе только 5% из совершенных преступлений.

Интересный факт: в 2018 году компания-разработчик проводила исследование на тему возможной «предвзятости» продукта и пришла к выводу, что алгоритм указывает именно на черных и латинос на 400% чаще, нежели белых (по крайней мере в выбранной локации). Однако эти результаты не были переданы полиции, так как «исследование носило академический характер».

Авторы исследования попытались реализовать «твик», который влиял на распределение потенциальных правонарушений в социуме (избавляясь от превалирования определенных групп людей по расовому признаку). Это привело к расхождениям с отчетами полиции, однако все равно заявлялось, что «точность выше, нежели если бы ее делали люди». А от модернизации ПО отказались, так как это привело бы к «росту виктимизации и снижению защищенности уязвимых районов».

На основании этой информации можно сделать вывод: ориентируясь на отчеты, PredPol прогнозировало преступления там, где они чаще фиксируются (логично). При этом на фоне меньшего количества регистрируемых преступлений в «белых» и «богатых» районах ПО, сравнивая показатели, дополнительно уменьшало в последних «вес» правонарушений (ошибочное суждение, неравенство и «компьютерный предрассудок»). График выше является косвенным тому подтверждением, а Джумана Муса из организации Fourth Amendment Center сравнивает подобные прогнозы с попыткой поставить пациенту диагноз, не учитывая половину симптомов.

Более того, влияние на алгоритмы оказывает и сам факт внесения или невнесения информации о том или ином преступлении. Так, по информации отдела по сбору статистики американского минюста, в полицию сообщают только о 40% преступлений, связанных с насилием, и менее чем о трети совершенных имущественных преступлений. И чем богаче жертва, тем с меньшей вероятностью она сообщит о преступлении против себя (то же касается и белых). Отсюда и больше прогнозируемых преступлений в одних регионах и исключения из предсказаний в других.

Статистика относительно того, реагировала ли полиция на предсказания искусственного интеллекта и привели ли они к выявлению преступников, практически отсутствует (обычно ею отказываются делиться). Лишь 13 из 38 полицейских департаментов, которым были отправлены запросы, ответили. Большинство сослались на то, что PredPol они больше не используют, в одном заявили, что ИИ позволил им более эффективно использовать ресурсы.

В ответ эксперты отмечают, что прогноз PredPol мог приводить к возникновению феномена самореализующегося пророчества (упрощенно: полиция ждет преступления — действует иначе — находит преступление). К тому же ИИ часто отправлял полицию в изначально «неблагоприятные» районы — которые являлись таковыми еще до появления специализированного программного обеспечения. Копы как бы получали подтверждение: «Да, это плохое место, здесь надо действовать еще жестче». А использование ПО к тому же снимало с полицейских ответственность за принятие решений.

К чему все в итоге привело? Полицейские участки, которые платили от $20 тыс. до $100 тыс. в год в зависимости от размера подотчетной территории за обслуживание PredPol, отказались от применения «предсказательной машины». Причина: даже компьютер не смог справиться с расовыми предрассудками. А сама компания, как и ПО, сменила название на Geolitica, и теперь предоставляет все те же услуги по анализу преступности, но уже не в формате «Особого мнения».

Читайте также:

- Топ CEO, которые едва не угробили свои технологические компании. А у кого-то получилось

- Восторг или провал? Рецензия на блокбастер «Матрица: Воскрешение»

Наш канал в Telegram. Присоединяйтесь!

Есть о чем рассказать? Пишите в наш телеграм-бот. Это анонимно и быстро

Перепечатка текста и фотографий Onlíner без разрешения редакции запрещена. ng@onliner.by